友情提示

本站部分转载文章,皆来自互联网,仅供参考及分享,并不用于任何商业用途;版权归原作者所有,如涉及作品内容、版权和其他问题,请与本网联系,我们将在第一时间删除内容!

联系邮箱:1042463605@qq.com

相关文章

近七日浏览最多

最新文章

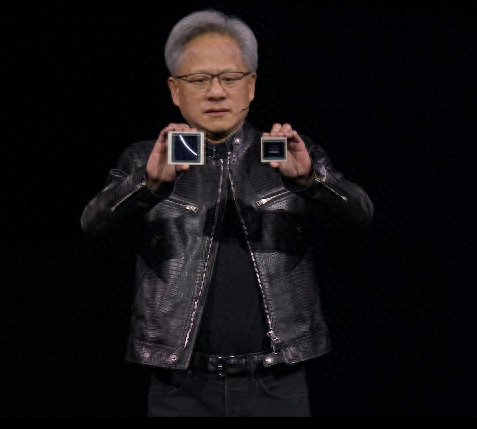

驱动中国2024年3月19日消息,在今日召开的GTC开发者大会上,英伟达公司正式推出了其最新的AI加速卡——Blackwell GB200。这款加速卡基于全新的Blackwell架构,预计将在今年晚些时候向市场发货。英伟达的首席执行官黄仁勋,在大会上表示,尽管之前的Hopper架构已经取得了显著成就,但为了应对日益增长的计算需求,开发团队需要打造一款更强大的GPU。

据了解,英伟达一贯遵循每两年升级一次GPU架构的策略,以此实现性能的飞跃式提升。继2022年推出基于Hopper架构的H100加速卡后,英伟达如今推出的Blackwell架构加速卡在性能上实现了重大突破,尤其在处理AI相关任务方面表现出色。

Blackwell GPU采用台积电4纳米工艺制造,集成了两个独立制造的裸晶(Die),内含2080亿个晶体管。通过NVLink 5.0技术,这两个芯片像拉链一样紧密连接。黄仁勋指出,Blackwell的AI性能达到了惊人的20 petaflops,是H100的五倍。这种增强的处理能力将使AI公司能够训练规模更大、结构更复杂的模型。

GB200不仅包含了两个B200 Blackwell GPU,还配备了一个基于Arm架构的Grace CPU。据英伟达官方数据显示,GB200在推理大型语言模型方面的性能比H100提高了30倍,而成本和能耗却仅为后者的四分之一。

此次发布的NVIDIA Grace Blackwell生产板和开发板,标志着英伟达在AI硬件领域的又一次飞跃。英伟达官方报告称,训练一个拥有1.8万亿参数的模型过去需要8000个Hopper GPU和15兆瓦的电力,而现在只需2000个Blackwell GPU,耗电量也降至4兆瓦。

在针对具有1,750亿参数的GPT-3 LLM基准测试中,GB200的性能是H100的7倍,训练速度则是H100的4倍。这一成果不仅凸显了Blackwell架构的强大能力,也预示着AI研究和应用领域即将迎来新的发展机遇。

为了满足大型企业的需求,英伟达还提供了成品服务器解决方案,如GB200 NVL72服务器,该服务器配备36个CPU和72个Blackwell GPU,并采用了一体水冷散热方案。这样的配置可以实现高达720 petaflops的AI训练性能或1,440 petaflops的推理性能。服务器内部的电缆总长度接近两英里,包含5000条独立电缆,展现了英伟达在高性能计算领域的深厚实力。

英伟达透露,亚马逊、谷歌、微软和甲骨文等公司已计划在其云服务产品中提供NVL72机架。特别值得一提的是,亚马逊AWS计划采购由2万片GB200芯片组成的服务器集群,以部署高达27万亿参数的模型。

此外,英伟达还提供了其他定制化解决方案,例如DGX GB200的DGX Superpod,它将八个系统合而为一,总共拥有288个CPU、576个GPU、240TB内存和11.5 exaflops的FP4计算能力。英伟达表示,其系统可扩展至数万GB200超级芯片,并通过Quantum-X800 InfiniBand或Spectrum-X800以太网与高速网络连接。

尽管英伟达尚未公布GB200及整套方案的售价信息,但其在AI加速卡市场的领先地位无疑将进一步巩固。随着这些新产品的上市,AI领域的发展将迎来新的历史篇章。

友情提示

本站部分转载文章,皆来自互联网,仅供参考及分享,并不用于任何商业用途;版权归原作者所有,如涉及作品内容、版权和其他问题,请与本网联系,我们将在第一时间删除内容!

联系邮箱:1042463605@qq.com