SD(Stable Diffusion)是目前最流行的本地部署类AIGC工具,它可以说既简单又复杂。简单是因为完全没有绘画功底的用户也可以做出各种风格的精美图片,而复杂则是因为AIGC相对没有那么“听话”,想要AI完全按照自己的想法实现内容还是颇有难度的。

此前我们简单介绍过大家最常用的文生图,今天就来讲一讲SD更实用的图生图功能。它相比文生图具有在原图基础上更可控、更简单、更还原等优点,但如果是初次接触,想要用好还是比较困难的,下面我们就来简单的讲一讲如何控制图生图中的变量达到想要的效果。

1 模型的选择 准备工作

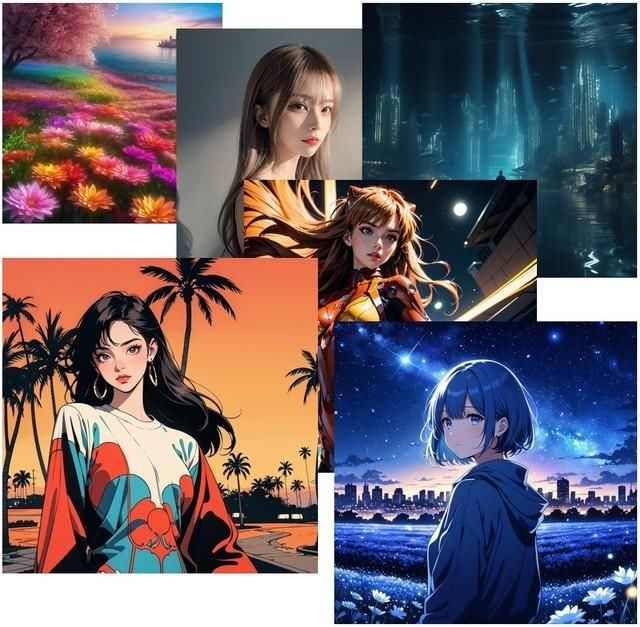

在SD中,不同的模型有不同的绘画风格,相信使用过文生图的朋友都有体会,有的模型擅长动漫人物、有的擅长真人、有的则擅长风景。

这一点在图生图中同样比较重要,如果选择人物模型,却想要生成纯风景就非常困难,即便反向词加上各种限制,大概率出图后也会有一个奇形怪状的人物出现。

目前从个人使用的情况来看,动漫类aamXLAnimeMix、astranime效果都是不错的;真人则是chilloutmix;纯风景的比较少,使用SDXL即可。

除了模型之外,硬件也是准备工作的重要环节,不管是文生图还是图生图,显卡始终是冲在最前线的。如果你想生成大尺寸的图片,显存是最重要的,如果显存需求高于实际显存,则会直接报错,无法生成。

不过如果你只需生成单张图片,使用高清修复功能同样可以解决分辨率的问题。此前笔者由于需要使用SD生成出视频对应的多张图片,所以直接按照视频的尺寸生成了1800×1200分辨率。

对于SD来说,生成简单的图12GB显存大都够用,如果生成较大较精细的图片,建议16GB或以上显存。目前RTX 40系显卡中RTX 4070 Ti SUPER和RTX 4080 SUPER都是16GB,我们的测试平台使用的为华硕TUF GeForce RTX 4080 SUPER O16G GAMING显卡(毕竟收钱了)。

不过在算力上RTX 4080 SUPER也要比RTX 4070 Ti SUPER强很多,10张图片大约能提升30s左右。毕竟使用SD不管是文生图还是图生图,都是碰运气的事,验证阶段生成几十几百张图很常见。

2 反推

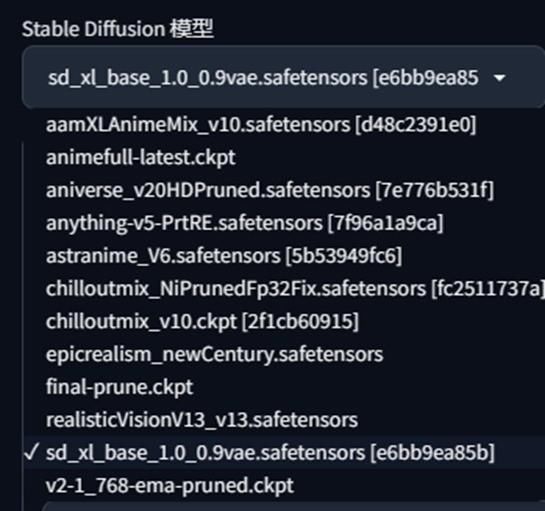

下面我们直入正题,SD图生图与文生图最大的区别就是需要反推提示词。虽然SD会自带反推,但还是建议大家直接下载秋叶大神的整合包,里面自带了WD1.4标签器,傻瓜式操作、速度快、准确度高。

1girl, hat, solo, phone, long hair, cellphone, holding, holding phone, smartphone, blue headwear, realistic, jacket, black hair, upper body, brown hair, baseball cap, grey background, long sleeves, simple background, black eyes

从上图的反推来看,WD1.4标签器生成的准确度相当高,而且可一键发送到图生图,非常方便。

这步不需要什么注意事项,只是在筛选标签的时候,可以删除或替换为自己想要生成的目标。

3 参数设置

在SD图生图中,参数的设定和文生图有些区别,这里简单说明。

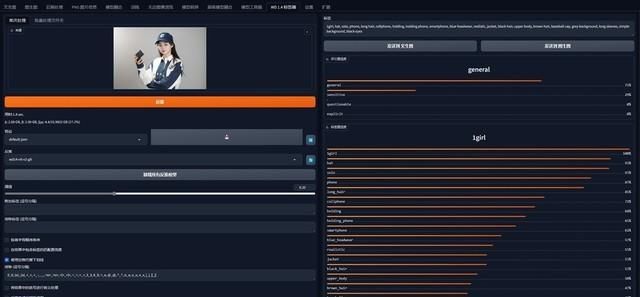

迭代步数

迭代步数的数值与文生图相同,简单可以理解为AI通过多少步的计算得到的这张图片,通常设定在20-50之间,过低或过高都可能造成画面崩坏。

然而不同的模型,对迭代步数的需求都不同。通常来讲在漫画模型中,Steps在20左右即可生成不错的图片,但很多真人模型Steps 20生成的图片则会显得假一些,将数值设定在40-50左右会有不错的效果。

另外迭代步数越高,生成图片的时间越慢,反之则快。但最终生成的图片大小都是相同的。

重绘尺寸

由于SD图生图通常是将真实拍摄的照片导入作为参考,如果是原图,则需要进行缩放处理,否则会由于图片过大而显存报错。

如果想保持原图比例,选择倍数缩放即可;如果想自定义,直接输入想要的尺寸即可。这一项很简单,无需太多说明。

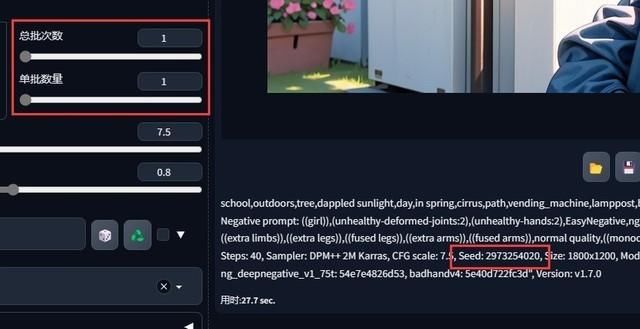

批次

总批次数和单批数量也很好理解,总批次数越大,代表AI随机种子生成的数量越多;而单批数量则是在同一种子的情况下,使用相同设定生成更多的图片。

这两项数值的设定没有绝对值,通常前期实验阶段的总批次数会多一些,以作为参考。如果发现了喜欢的风格或构图,可以查看当前图片的Seed值,将这个值复制到随机数种子中(默认为-1),再生成单批多数量图片。

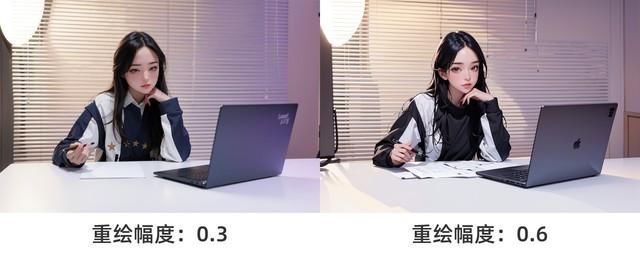

引导系数与重绘幅度

这两项参数是与文生图区别最大的地方,在文生图中,提示词引导系数基本是单一决定出图效果的变量(除了提示词)。

而在图生图中,引导系数会被极大弱化,它与重绘幅度是相辅相成的关系。

简单来说,重绘幅度越小,它与原图就越相似,AI发挥的空间就越小。而重绘幅度在0.5或0.6之后,AI发挥的就越自由。

同时这也会大幅提高画面崩坏的几率,虽然AI的自由度高了,但是图生图的逻辑仍是在原图的基础上修改,所以当两种设定相冲突时,就会产生崩坏的画面。

想要得到自己满意的图生图效果,就需要在引导系数与重绘幅度之间反复调试,以掌握自己满意的AI重绘区间。在掌握了大体的区间后,笔者通常将重绘幅度以0.02作为步进区间。

4 标签

虽然图生图是以原图作为依据进行重绘,但标签仍然会起到相当大的作用。另外在SD中,一些反向标签是通用的,大家可以直接复制到记事本中,以便下次直接取用。如果是人物图片,基本以多余的手、四肢、低质量为主。

(unhealthy-deformed-joints:2),(unhealthy-hands:2),EasyNegative,ng_deepnegative_v1_75t,(worst quality:2),(low quality:2),(normal quality:2),lowres,bad anatomy,badhandv4,((extra limbs)),((extra legs)),((fused legs)),((extra arms)),((fused arms)),normal quality,((monochrome)),((grayscale)),((watermark)),uneven eyes,lazy eye,(((mutated hand))),

以原图作为参考,一些较为相似的部位,如图中皖之的头发、眼神,在重绘幅度较大的情况下,AI可以根据提示词自行修改。

但身后标志性较强的百叶窗,如果你想让AI重绘成黑色的柜子,则很难实现。除非将重绘幅度继续调大,但随之而来的后果就是画面崩坏更严重。

所以这时我们就需要用到局部重绘。

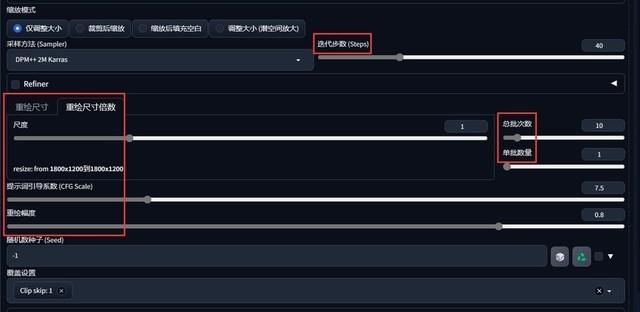

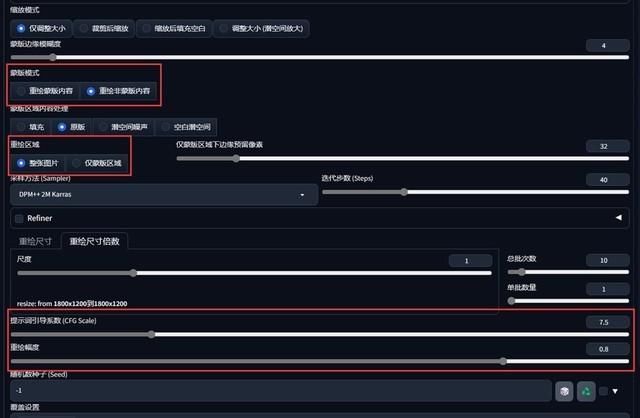

5 局部重绘

蒙版重绘顾名思义,就是圈出图中需要AI重新生成的地方。它的作用是帮助我们在已经生成出合适的人或背景之后,固定某一区域,重新生成其他区域的内容。

如图中所示,我们已经生成了相当完美的角色。手部和姿势都已经相当完美,所以这时候仅需更改背景即可。

重绘的工具SD里面提供的比较简单,只有一个圆形画笔。大家可根据人物结构的不同,随时调整画笔大小。

如果想要更严谨的区域,也可以上传原始图像和黑白蒙版,这样能够最大限度保证边缘结构的准确性。

局部重绘除了框定选区范围之外,所有参数也要重新设置。毕竟它只是在原图的基础上刨除了一部分,仍然相当于重新作画。

这里需要注意的是,在蒙版模式中要区分让AI绘制蒙版内或者反选区域的内容。另外如果需要生成完全不同的背景,在重绘幅度上可以调大参数。

最后就是记得更改提示词,从标签页复制过来的提示词仅适用于原始图像,想大幅度改变背景,提示词需重新定制。

6 总结

图生图是SD重非常有用的一项功能,而且它相比文生图效果更直接。大家不妨找一些身边的朋友,把他们的照片变为AI风格,一定会让大家啧啧称奇。

另外文中没有提及【ControlNet】,这是一个功能极强的插件,使用它可以时间自定义姿势、保障面部表情、手指准确性、给老照片上色、给线稿上色等等。不过相对应的使用起来也比较繁琐,如果大家想看更多关于AIGC的小技巧,下次我们可以单独来讲一期ControlNet插件。

最后,AIGC生图永远不会按照我们大脑想的意志来,只能是无限接近。所以如果想达到最好的效果,还要结合自身的绘画功底来对图片进行完善。

(8607821)

友情提示

本站部分转载文章,皆来自互联网,仅供参考及分享,并不用于任何商业用途;版权归原作者所有,如涉及作品内容、版权和其他问题,请与本网联系,我们将在第一时间删除内容!

联系邮箱:1042463605@qq.com