友情提示

本站部分转载文章,皆来自互联网,仅供参考及分享,并不用于任何商业用途;版权归原作者所有,如涉及作品内容、版权和其他问题,请与本网联系,我们将在第一时间删除内容!

联系邮箱:1042463605@qq.com

相关文章

近七日浏览最多

最新文章

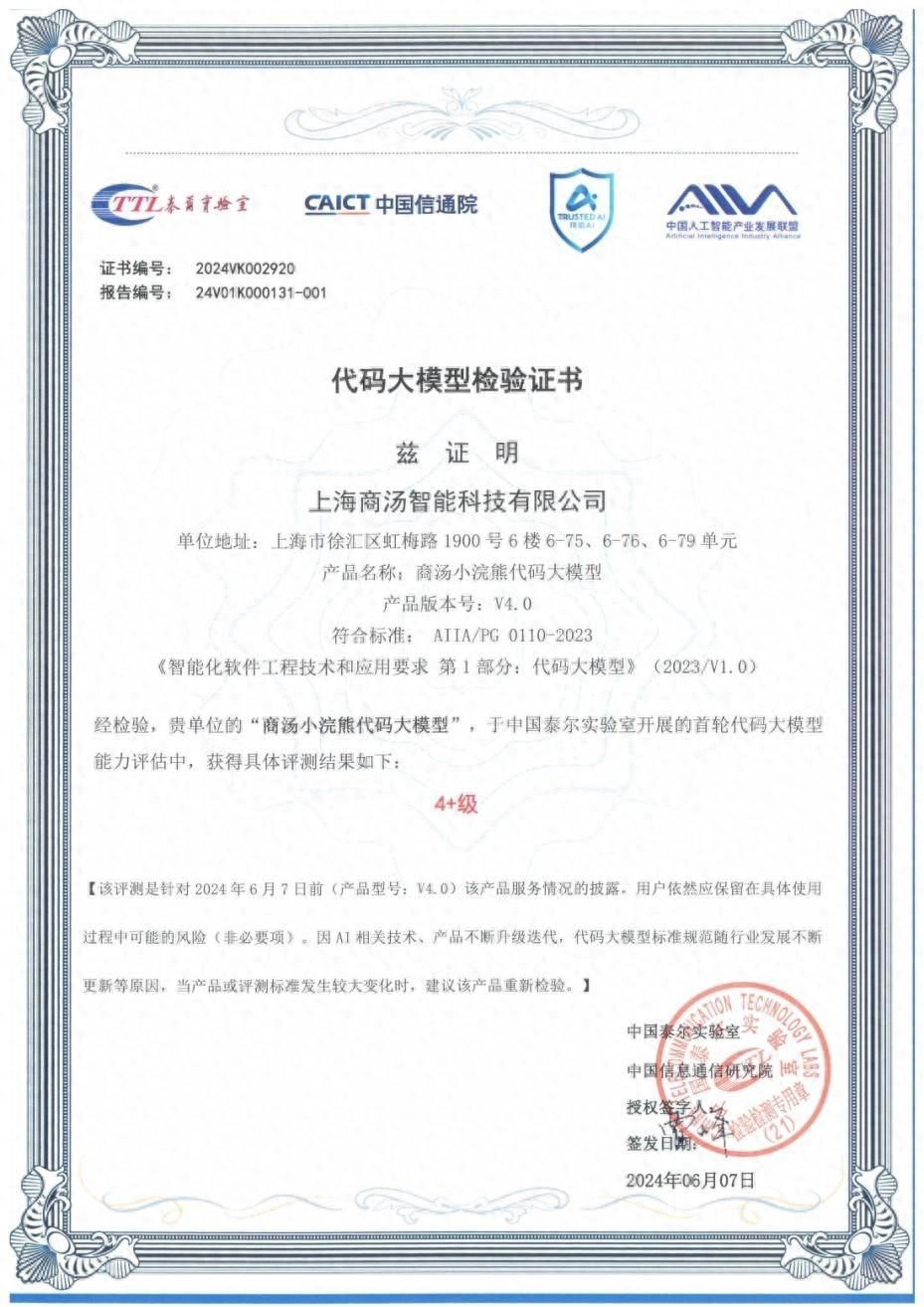

6月11日,中国信息通信研究院(以下简称“信通院”)公布可信AI代码大模型首轮评估结果,商汤小浣熊获得最高评级(4+级),在代码通用能力、专用场景和应用成熟度多个评估维度中表现优秀。

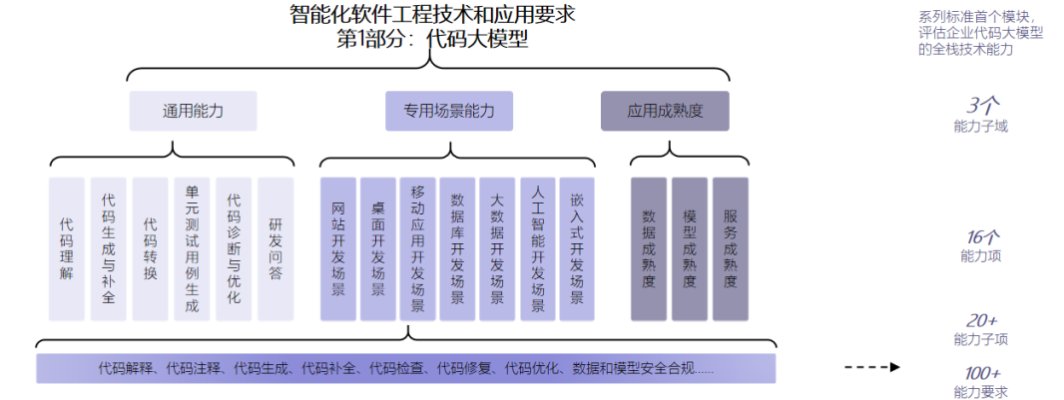

信通院在2024上半年正式启动可信AI代码大模型评估,以《智能化软件工程技术和应用要求 第1部分:代码大模型》标准为评估依据,该标准也是业内首个代码大模型标准,其涵盖通用能力、专用场景能力和应用成熟度三大部分,包括16个能力项、100多个能力要求,全面从输入多样性、任务多样性、语言完备度、结果可接收性、结果准确度等维度,考核代码大模型的全栈技术能力。

图片来源:中国信息通信研究院

商汤小浣熊是本次评分最高的代码大模型之一,作为首批参评企业获得4+级评级,信通院给出测评结论:

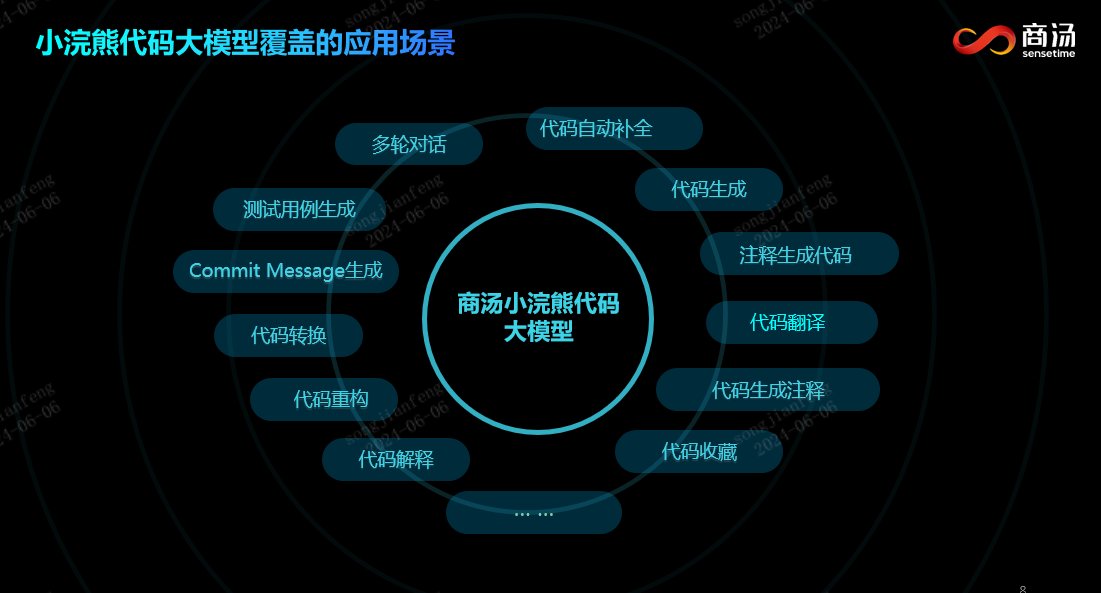

在通用能力方面,其代码解释、代码转换等方面表现突出;

在专用场景方面,其支持网站开发、桌面应用开发、移动应用开发、数据库开发等多个场景的开发能力;

在应用成熟度方面,其数据分类分级、模型性能、模型服务可维护性、风险可控性等方面均表现优秀。

「小浣熊家族」是基于商汤“日日新SenseNova”大模型体系打造的 AI Native 生产力系列工具,覆盖软件开发、数据分析、编程教育等多个场景,旨在通过先进的人工智能技术优化和提升工作效率。

小浣熊家族现已推出代码小浣熊和办公小浣熊两位产品成员。

官网链接:https://raccoon.sensetime.com/login?utm_source=JUNEXTY

其中,代码小浣熊是基于大模型的软件智能研发助手,覆盖软件需求分析、架构设计、代码编写、软件测试等环节,满足用户代码编写、编程学习等各类需求,现已支持Python、Java、JavaScript、C++、Go、SQL等90+主流编程语言和VS Code, JetBrains全家桶, Android Studio等主流IDE。

办公小浣熊则是基于大模型的大模型原生数据分析产品,可以通过用户的自然语言输入,自动将数据转化为有意义的分析和可视化结果。

小浣熊家族背后的「小浣熊代码大模型」,在权威测试集HumanEval Coding测试中一次通过率达到78.1%,在数据分析场景下的数据测试集(1000+题目)中以85.71%的正确率超过GPT-4。

小浣熊代码大模型自上线以来,累计为10万+个人用户提供服务,单日代码生成数量达到10亿+Tokens,总体平均代码采纳率超过30%,用户编码能效提升达到20%~78%。

在企业用户方面,商汤小浣熊代码大模型已经被包括金融、新能源汽车等行业在内的200+以上企业客户使用,凭借其突出的数理能力覆盖多元落地场景。

例如,在与金山办公的合作中,小浣熊代码大模型凭借卓越的代码生成及工具调用能力助力WPS 365打造更高效释放场景能力的智能办公平台,为用户多元、碎片化的办公需求提供新质生产力。

在金融领域,基于小浣熊代码大模型,商汤科技与海通证券合作打造智能研发助手,辅助金融企业研发人员进行代码编程,为开发者提供代码智能补全与对话问答服务,可辅助生产代码约20%代码,降低开发技术门槛,有效提高开发效率。在减少开发者重复工作同时,还能帮助团队更早发现并修正开发中的错误,提升软件交付质量。

未来,商汤小浣熊将持续降低大模型技术的开发和应用门槛,赋能更多场景实现创新。

友情提示

本站部分转载文章,皆来自互联网,仅供参考及分享,并不用于任何商业用途;版权归原作者所有,如涉及作品内容、版权和其他问题,请与本网联系,我们将在第一时间删除内容!

联系邮箱:1042463605@qq.com