友情提示

本站部分转载文章,皆来自互联网,仅供参考及分享,并不用于任何商业用途;版权归原作者所有,如涉及作品内容、版权和其他问题,请与本网联系,我们将在第一时间删除内容!

联系邮箱:1042463605@qq.com

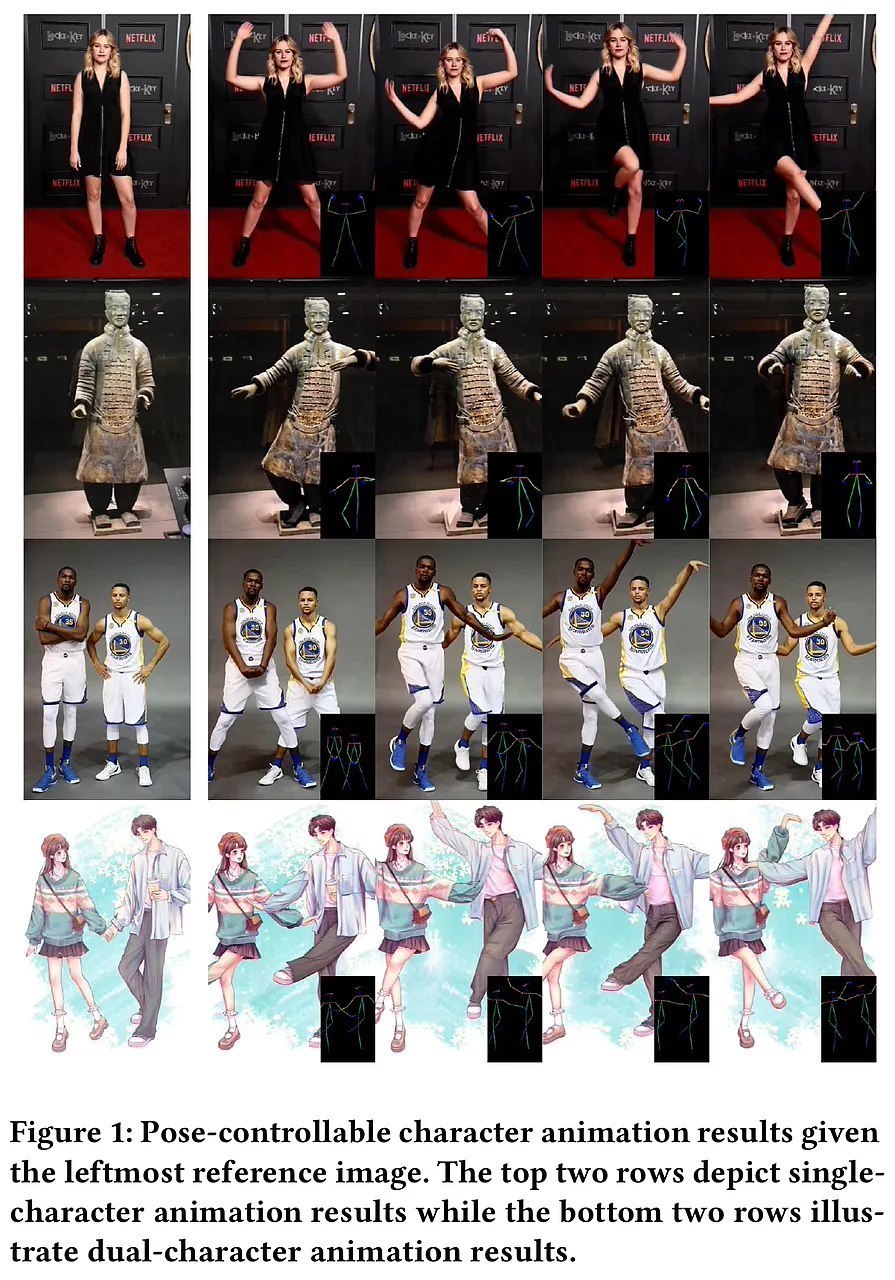

腾讯联合中山大学、港科大推出图生视频模型Follow-Your-Pose-v2

9

0

相关文章

近七日浏览最多

标签云

香港科技大学

计算机科学

商学院

清华大学

人工智能

华南农业大学

高校

中山大学

暨南大学

广东

围棋

中国传统文化

谢尔豪

香港中文大学

初创公司

香港

刘炜

广州

blazer

腾讯

创新创业

基金

智能驾驶

小米

世界大学排名

扬州大学

南方科技大学

港元

汪滔

爱因斯坦

香港大学

奥斯卡

美国

白宫

探测器

引力波

中国科学院

行星

科学家

华中科技大学

机器人

研究院

郑则仕

北美市场

新能源汽车

大疆

无人机

github

城际铁路

本科

闫罗彬

副教授

白血病

西南大学

朱孔军

副部长

党委书记

广东省委

中央组织部

读博

兼职

博士

离世

奖学金

复旦大学

世界大学

世界杯

李教授

清华

共产国际

莫斯科

苏联

风筝

旗开得胜

985高校

深圳大学

投档线

录取通知书

傅园慧

跆拳道

刘伟

浙大

指数

研究生

大手牵小手

爷爷奶奶

扫地机器人

肿瘤

乳酸

癌细胞

华南理工大学

野鸡大学

大学

华南师范大学

老年痴呆

不良习惯

阿尔茨海默病

小米集团

减持

免疫治疗

肺癌

基金会

股票

万军伟

股份

周迅

杨洋

吴磊

赵露思

top

虞书欣

永夜星河

珠帘玉幕

贵女

古装

陈都灵

何泓姗

清纯女神

王炸

胡定欣

黎耀祥

女强人

墨雨云

大女主剧

影视

改编

赴山海

电视剧

许我耀眼

上甘岭电影

黑马

收视率

张新成

王玉雯

轻喜剧

优秀女演员奖

张丰毅

温峥嵘

任嘉伦

实力派演员

亲密

窗影

会议室

内外部

滨海大厦

微信

苹果16

华为手机

苹果中国

应用商店

apple

ios系统

iphone

开发者测试版

苹果

安卓手机

iphone手机

谷歌

ios

苹果公司

短剧

电影

剧版

新风口

蓝海赛道

ipad

word

聊天记录

美国司法部

抖音

长文

etf

中国太保

科创板日报

kimi

融资

快科技

现实世界

刘强东

京东集团

拼多多

世界500强

京东

阿里

pdf

腾讯控股

nlp

蔡崇信

东南亚地区

米哈游

王者荣耀

越南

莉莉丝

原神

app

微信支付

苹果手机

字节跳动